Resenha de Artigo: “Privacy in the Age of AI”, de autoria de Sauvik Das, Hao-Ping (Hank) Lee e Jodi Forlizzi

por Rafael José Godoi, em 10 de setembro de 2024

É evidente o quanto impactante uma IA generativa pode afetar a vida das pessoas.O artigo “Privacy in the age of AI” aborda a questão dos riscos de segurança quando usamos IAs sem uma melhor ideia dos possíveis problemas. Desde 2020, há alguns acontecimentos que exemplificam a afirmação anterior, entre elas é o caso do uso da IA ClearView para identificar manifestantes do movimento Black Lives Matter e a artista que descobriu que suas fotos privadas de um laudo médico estavam sendo usadas como dados para treinar um modelo de IA.

Já é de conhecimento comum que IAs prometem muitos benefícios, como a melhoria em diagnósticos em doenças, a democratização da cultura e a aceleração do ritmo do trabalho. Entretanto devemos nos atentar aos perigos criados a partir do abastecimento de dados sem devida infraestrutura, pois isso gera novos tipos de danos à privacidade digital.

Antes de entender melhor sobre essas mudanças na privacidade provocadas pelas IAs, devemos nos atentar que IA é um tema muito abrangente e, por isso, vamos restringir ao comentar sobre uma subárea desse campo que é o aprendizado de máquina. Esse campo se concentra no desenvolvimento de sistemas que melhoram automaticamente através do uso de dados e são considerados altamente eficazes para os quais se propõem, entre eles estão: identificar objetos em imagens, gerar texto em linguagem natural e fazer previsões fundamentadas sobre tendências futuras. Essa alta eficácia gerou um crescente interesse pelo uso de dados pessoais com o objetivo de alimentar o sistema.

Seguindo no contexto sobre privacidade, faz-se importante compreender melhor o conceito por trás dessa palavra. Ao olhar com mais atenção esse tópico, os autores perceberam que não é algo tão simples de definir pois existem muitas camadas que prejudicam a elaboração de uma conceituação mais objetiva. Sob esse ponto de vista, o filósofo Judith Jarvis Thomson disse uma vez: “Talvez a coisa mais surpreendente sobre o direito à privacidade é que ninguém parece ter uma ideia muito clara do que ela é”. Dito isso, o professor de direito Daniel J. Solove propôs uma taxonomia da privacidade para organizar as preocupações e ameaças nesse âmbito.

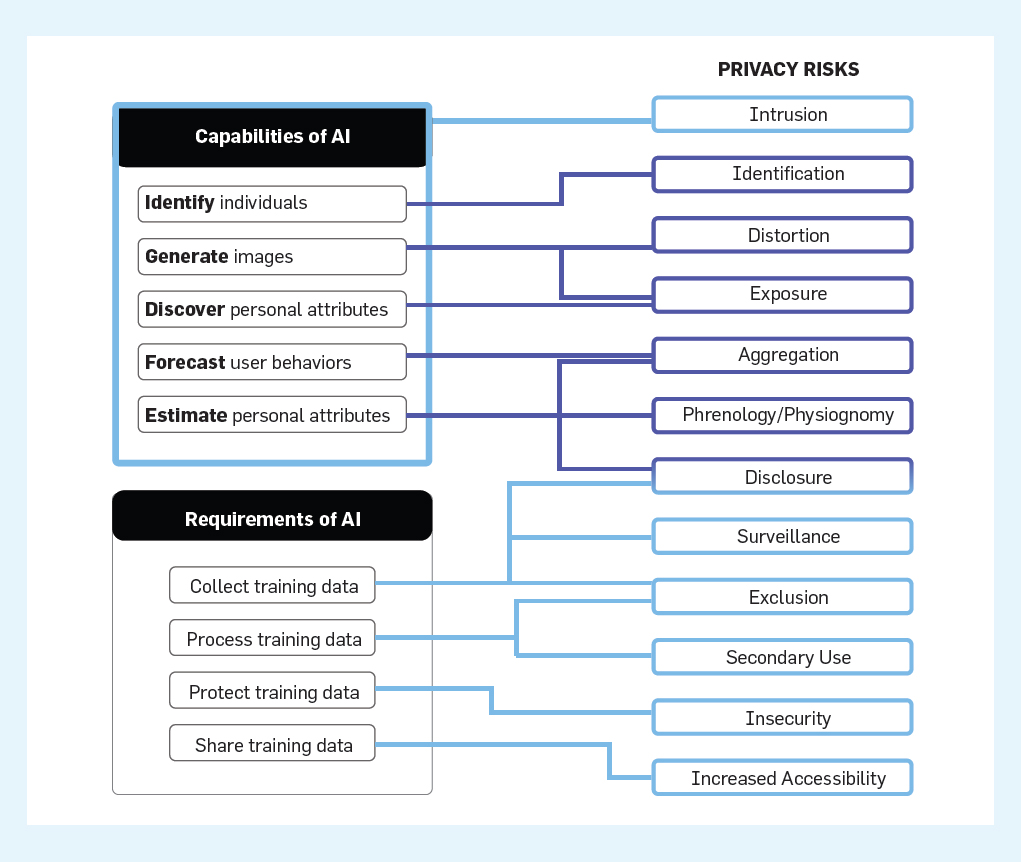

Como os requisitos e capacidades das IAs mudam a privacidade ? Apesar de muito se especular sobre as proporções dessas inteligências , grande parte é especulativa e por isso devemos nos atentar à realidade. Baseando no Algorithmic and Automation Incident and Controversy Repository (AIAAIC), o artigo analisou 321 incidentes de privacidades e com base na taxonomia de Solove, descobriram que os requisitos de dados da IA exacerbam intrusões de privacidades em 12 categorias de alto nível : intrusão, identificação, distorção, exposição, agregação, frenologia/fisionomia, divulgação, vigilância, exclusão, uso secundário, insegurança e maior acessibilidade. Logo, foi possível afirmar que existem novos tipos de violações ou intensificações das existentes.

Os autores trazem ainda alguns questionamentos interessantes: Os profissionais estão equipados para atenuar as ameaças à privacidade exacerbadas pela IA? Como o pipeline de design para IA difere dos pipelines tradicionais, o artigo conseguiu entrevistar 35 profissionais da área para compreender o quão estavam conscientes dessas ameaças à privacidade. Esses profissionais mostraram um conhecimento baixo sobre as formas como os produtos ou serviços criam ou ultrapassam os limites da privacidade, há também mais inibidores que motivadores para trabalhar com privacidade. Nesse contexto, quando os profissionais se depararam com conflitos dos objetivos dos produtos, isso acaba por impedir o cumprimento dos padrões mínimos de privacidade que não eram específicos de IA. Ademais, descobriram que os profissionais confiaram em auditorias automatizadas para ajudar a minimizar os riscos , mas como esses elementos não são específicos para seus softwares. Por fim, o resultado foi uma insatisfação dos técnicos pela falta de preparo ao lidar com o assunto de privacidade e uma discussão sobre a necessidade de mais orientações sobre o tema.

A questão que fica, após visualizar todas essas mudanças a partir das IAs, é qual é o melhor caminho para mitigar o problema e preparar os profissionais? O artigo propõe que a primeira mudança a ser realizada seja uma definição sobre os termos nebulosos. Isso pode contribuir para os profissionais se atentarem a riscos específicos de privacidade e saberem quando alguma tecnologia provoca a ameaça à segurança. Faz se importante também aproveitar o poder da comunidade para potencializar os conhecimentos sobre esse campo, fornecendo uma melhor orientação e motivação para os desenvolvedores. Além das ideias anteriores, é possível usar uma metodologia de design chamada “Privacidade através do Design” que abrange um conjunto de ferramentas que auxiliam os profissionais a compreender a intrusividade das IAs. Portanto, essa abordagem poderá trazer uma maior consciência sobre a questão dos riscos da privacidade quando usamos IA e teremos uma maior possibilidade de mitigar os danos causados.

- Efetue login ou registre-se para postar comentários